Parece que NVIDIA decidió repetir este camino de anuncios en la línea de las mejores soluciones gráficas, lo que se puede expresar con la secuencia “GeForce GTX 980 –> GeForce TITAN X –> GeForce GTX 980 Ti”, solo que ahora las tarjetas de video se basan en Los núcleos GP104/102 de la arquitectura Pascal y se lanzan de acuerdo con la tecnología de proceso de 16nm. Con la primera tarjeta de video, NVIDIA GeForce GTX 1080, ya me encontré, como con ella versiones originales. Ahora es el momento de explorar la tarjeta gráfica de rendimiento fenomenal y más nueva de NVIDIA, TITAN X.

La novedad comenzó a costar $ 200 más que su predecesora: $ 1200 y, por supuesto, todavía se posiciona como una tarjeta de video profesional para investigación y aprendizaje profundo. Pero, como probablemente comprenda, lo que más nos interesa es su rendimiento en aplicaciones de juegos y puntos de referencia gráficos, ya que todos los jugadores esperan con ansias el anuncio de la GeForce GTX 1080 Ti, cuyas últimas señales ya han privado a los adeptos más obvios de la compañía. de dormir. Sin embargo, hoy probaremos la NVIDIA TITAN X en puntos de referencia informáticos separados para asegurarnos de que funciona bien como tarjeta gráfica profesional.

1. Revisión de la tarjeta de súper video NVIDIA TITAN X 12 GB

especificaciones de la tarjeta de video y costo recomendadoLas características técnicas y el costo de la tarjeta de video NVIDIA TITAN X se muestran en la tabla en comparación con la referencia NVIDIA GeForce GTX 1080 y la versión antigua de GeForce GTX TITAN X.

embalaje y equipo

NVIDIA ha reservado el lanzamiento de TITAN X estrictamente para sí mismo, por lo que el empaque de la tarjeta de video es estándar: una caja compacta que se abre y una tarjeta de video insertada en su centro en una bolsa antiestática.

No hay nada en el paquete, aunque hay un compartimento adicional en el interior. Recuerde que el costo recomendado de NVIDIA TITAN X es de 1200 dólares estadounidenses.

Diseño y características de PCB

El diseño de la nueva NVIDIA TITAN X se ha vuelto más atrevido o incluso agresivo que el diseño de la GeForce GTX TITAN X. La carcasa del sistema de enfriamiento en la parte frontal de la tarjeta de video se dotó de bordes adicionales que brillan bajo los rayos de luz, y la parte posterior de la textolita estaba cubierta con una cubierta corrugada hecha de metal.

Junto con un rotor de ventilador cromado y la misma inscripción en la parte frontal, la tarjeta de video se ve realmente elegante y atractiva. Tenga en cuenta que en el extremo superior de NVIDIA TITAN X, quedan los símbolos brillantes "GEFORCE GTX", aunque ya no están en el nombre de la tarjeta de video.

La tarjeta de video de referencia tiene 268 mm de largo, 102 mm de alto y 37 mm de grosor.

Las salidas de vídeo del panel perforado adicionalmente con agujeros triangulares son las siguientes: DVI-D, tres DisplayPort versión 1.4 y una HDMI versión 2.0b.

En este sentido, la novedad no tiene cambios en comparación con la GeForce GTX 1080.

Se proporcionan dos conectores en la tarjeta de video para crear varias configuraciones SLI. Las opciones SLI de 2, 3 y 4 vías para combinar tarjetas de video se admiten utilizando puentes de conexión rígidos nuevos y puentes flexibles antiguos.

Si la GeForce GTX 1080 de referencia tiene solo un conector de ocho pines para alimentación adicional, TITAN X también recibió un conector de seis pines, lo cual no es sorprendente, porque el nivel de consumo de energía declarado de la tarjeta de video es de 250 vatios, como la GeForce GTX TITAN X que la precedió.La fuente de alimentación recomendada para un sistema con una de esas tarjetas de video debe ser de al menos 600 vatios.

La placa de circuito impreso de referencia NVIDIA TITAN X es mucho más compleja que la placa GeForce GTX 1080, lo cual es bastante lógico dados los mayores requisitos de energía, mayor memoria de video y un bus de comunicación más amplio con ella.

El sistema de alimentación de la GPU es de cinco fases y utiliza elementos de alimentación Dr.MOS y condensadores de polímero de tantalio. Dos fases de energía más están dedicadas a la memoria de video.

El controlador uP9511P de uPI Semiconductor es responsable de la administración de energía de la GPU.

Las funciones de monitoreo son proporcionadas por el controlador INA3221 fabricado por Texas Instruments.

Fabricado en 16nm, el troquel GPU GP102 de 471 mm2 se lanzó la semana 21 de 2016 (finales de mayo) y pertenece a la revisión A1.

Además de las mejoras arquitectónicas en la línea de GPU Pascal, en comparación con NVIDIA GeForce GTX TITAN X GPU GM200, la nueva GP102 contiene un 16,7 % más de procesadores universales shader, y su número total es 3584. La ventaja en este indicador sobre la GeForce GTX GP104 1080 es un impresionante 40%. La misma alineación se da en cuanto al número de unidades de textura, de las cuales la nueva TITAN X cuenta con 224 piezas. Complementando los números GP102 hay 96 unidades de operaciones de trama (ROP).

Las frecuencias de GPU también han aumentado. Si la GeForce GTX TITAN X tenía una frecuencia de GPU base en modo 3D de 1000 MHz y podía aumentarse hasta 1076 MHz, entonces la nueva TITAN X tiene una frecuencia base de 1418 MHz (+41,8 %), y la frecuencia de aumento declarada es 1531 MHz. De hecho, según los datos de monitoreo, la frecuencia de la GPU aumentó brevemente a 1823 MHz y promedió 1823 MHz. Este es un aumento muy significativo con respecto a su predecesor. Agregamos que al cambiar al modo 2D, la frecuencia de la GPU cae a 139 MHz con una disminución simultánea de voltaje de 1.050 V a 0.781 V.

NVIDIA TITAN X está equipada con 12 GB de memoria GDDR5X, ensamblada con doce chips Micron (marca 6KA77 D9TXS), soldados solo en la parte frontal de la placa de circuito impreso.

En comparación con la GeForce GTX TITAN X anterior en GM200, la frecuencia de memoria de la nueva TITAN X en GP102 es de 10008 MHz, que es un 42,7 % más alta. Por lo tanto, con un ancho de bus de memoria sin cambios de 384 bits, el ancho de banda de la memoria TITAN X alcanza un impresionante 480,4 GB / s, que es solo un poco menos que el actual poseedor del récord en esta área: AMD Radeon R9 Fury X con su HBM de alta velocidad. y 512GB/s En el modo 2D, la frecuencia de la memoria se reduce a 810 megahercios efectivos.

El resultado de la revisión del hardware de la nueva tarjeta de video se resumirá en información de la utilidad GPU-Z.

También publicamos el BIOS de la tarjeta de video, leemos y guardamos con la misma utilidad.

sistema de refrigeración - eficiencia y nivel de ruido

El sistema de refrigeración NVIDIA TITAN X es idéntico al sistema de refrigeración NVIDIA GeForce GTX 1080 Founders Edition.

Se basa en un disipador de aluminio niquelado con una cámara de evaporación de cobre en la base, que es la encargada de refrigerar la GPU.

Este radiador tiene un área pequeña y la distancia intercostal no supera los dos milímetros.

Por lo tanto, no es difícil suponer que la eficiencia del enfriamiento de la GPU con este radiador dependerá en gran medida de la velocidad del ventilador (que, de hecho, se confirmó más tarde).

Se proporciona una placa de metal con almohadillas térmicas para enfriar los chips de memoria y los elementos de los circuitos de alimentación.

Para verificar el régimen de temperatura de la tarjeta de video como carga, usamos diecinueve ciclos de la prueba de esfuerzo Fire Strike Ultra del paquete 3DMark.

Para monitorear las temperaturas y todos los demás parámetros, se utilizó MSI Afterburner versión 4.3.0 Beta 14 y más reciente, así como la utilidad GPU-Z versión 1.12.0. Se llevaron a cabo pruebas en una caja cerrada de la unidad del sistema, cuya configuración puedes ver en el siguiente apartado del artículo, a temperatura ambiente 23,5~23,9 Grados celcius.

En primer lugar, probamos la eficiencia de refrigeración y el rendimiento térmico de NVIDIA TITAN X con un control de velocidad del ventilador completamente automático.

Modo automático (1500~3640 rpm)

Como puede ver en el gráfico de seguimiento, la temperatura de la GPU de NVIDIA TITAN X alcanzó muy rápidamente los 88-89 grados centígrados y luego, debido a un aumento relativamente fuerte en la velocidad del ventilador de 1500 a 3500 rpm, se estabilizó en alrededor de 86 grados. Celsius. Más adelante durante la prueba, la velocidad del ventilador aumentó aún más a 3640 rpm. Es poco probable que cualquiera de nosotros esperara de una tarjeta de video de referencia con un paquete térmico de 250 vatios otros indicadores de temperatura, que prácticamente no difieren de la GeForce GTX TITAN X.

A la velocidad máxima del ventilador, la temperatura del procesador de gráficos de la tarjeta gráfica NVIDIA TIAN X cae entre 12 y 13 grados centígrados en comparación con el modo de ajuste automático.

Velocidad máxima (~4830 rpm)

En ambos modos de ventilador, la NVIDIA TITAN X es una tarjeta gráfica muy ruidosa. Por cierto, NVIDIA no priva a los propietarios de este modelo de tarjeta de video de la garantía al reemplazar el enfriador de referencia con alternativas.

potencial de overclocking

Al comprobar el potencial de overclocking de NVIDIA TITAN X, aumentamos el límite de potencia al máximo posible en un 120 %, el límite de temperatura se elevó a 90 grados centígrados y la velocidad del ventilador se fijó manualmente en un 88 % de potencia o 4260 rpm. Después de varias horas de pruebas, logramos descubrir que sin pérdida de estabilidad y la aparición de defectos de imagen, la frecuencia base del procesador gráfico se puede aumentar en 225 MHz (+ 15,9 %), y la frecuencia efectiva de la memoria de video. en 1240 MHz (+ 12,4%).

Como resultado, las frecuencias de la NVIDIA TITAN X overclockeada en modo 3D ascendieron a 1643-1756/11248 MHz.

Debido a la dispersión significativa de las frecuencias de GPU durante la prueba de temperatura de la tarjeta de video overclockeada, la prueba del paquete 3DMark nuevamente informó sobre la inestabilidad de TITAN X.

A pesar de este hecho, los 19 ciclos de esta prueba, así como todos los juegos del conjunto de prueba, se aprobaron con éxito y, según los datos de monitoreo, la frecuencia central de la tarjeta de video overclockeada aumentó hasta 1987 MHz.

88% de potencia (~4260 rpm)

Dado el overclocking de la NVIDIA TITAN X de referencia, podemos suponer que la GeForce GTX 1080 Ti original hará overclocking aún mejor. Sin embargo, el tiempo lo dirá.

2. Configuración de prueba, herramientas y metodología de prueba

Las tarjetas de video se probaron en un sistema con la siguiente configuración:

placa base: ASUS X99-A II (Intel X99 Express, LGA2011-v3, BIOS 1201 a partir del 11/10/2016);

CPU: Intel Core i7-6900K (14 nm, Broadwell-E, R0, 3,2 GHz, 1,1 V, 8 x 256 KB L2, 20 MB L3);

Sistema de refrigeración de la CPU: Phanteks PH-TC14PE (2 Corsair AF140, ~900 rpm);

interfaz térmica: ARCTIC MX-4 (8,5 W/(m*K));

RAM: DDR4 4 x 4GB Corsair Vengeance LPX 2800MHz (CMK16GX4M4A2800C16) (XMP 2800MHz/16-18-18-36_2T/1.2V o 3000MHz/16-18-18-36_2T/1.35V);

tarjetas de video:

NVIDIA TITAN X 12GB 1418-1531(1848)/10008MHz y overclockeado a 1643-1756(1987)/11248MHz;

Gigabyte GeForce GTX 1080 G1 Gaming 8 GB 1607-1746(1898)/10008 MHz y overclockeado a 1791-1930(2050)/11312 MHz;

NVIDIA GeForce GTX 980 Ti 6 GB 1000-1076(1189)/7012 MHz y overclockeado a 1250-1326(1437)/8112 MHz;

disco para sistema y juegos: Intel SSD 730 480GB (SATA-III, BIOS vL2010400);

unidad de referencia: Western Digital VelociRaptor (SATA-II, 300 GB, 10 000 rpm, 16 MB, NCQ);

disco de respaldo: Samsung Ecogreen F4 HD204UI (SATA-II, 2 TB, 5400 rpm, 32 MB, NCQ);

tarjeta de sonido: Auzen X-Fi HomeTheater HD;

caja: Thermaltake Core X71 (cuatro ¡cállate! Silent Wings 2 (BL063) a 900 rpm);

panel de control y monitoreo: Zalman ZM-MFC3;

Fuente de alimentación: Corsair AX1500i Digital ATX (1500 W, 80 Plus Titanium), ventilador de 140 mm;

Monitor: Samsung S27A850D de 27" (DVI, 2560 x 1440, 60 Hz)

Por supuesto, no pudimos tener las versiones anteriores de la tarjeta de video TITAN X, por lo que compararemos el nuevo producto con otras dos tarjetas de video, pero nada lentas. La primera de ellas será la Gigabyte GeForce GTX 1080 G1 Gaming original, que probamos en las frecuencias de la NVIDIA GeForce GTX 1080 de referencia, así como con overclocking a 1791-1930/11312 MHz.

Tenga en cuenta que la frecuencia máxima del procesador gráfico de esta tarjeta de video durante el overclocking alcanzó los 2050 MHz.

La segunda tarjeta de prueba es la NVIDIA GeForce GTX 980 Ti de referencia, cuyo rendimiento probamos tanto a frecuencias nominales como con overclocking a 1250-1326(1437)/8112 MHz.

Dado que, en su lanzamiento, la GeForce GTX 980 Ti en los juegos demostró un rendimiento igual al de la GeForce GTX TITAN X anterior, esta comparación puede considerarse una comparación de dos TITAN X diferentes. Agregamos que los límites de potencia y temperatura en todas las tarjetas de video tienen se ha aumentado al máximo posible, y los controladores GeForce se establecieron en la prioridad de rendimiento más alta.

Para reducir la dependencia del rendimiento de la tarjeta de video en la velocidad de la plataforma, el procesador de ocho núcleos de 14 nm con un multiplicador de 40, una frecuencia de referencia de 100 MHz y la función Load-Line Calibration activada al tercer nivel fue overclockeado para 4,0 GHz cuando el voltaje en el BIOS de la placa base sube a 1.2095 V.

Al mismo tiempo, 16 gigabytes de RAM funcionaban a una frecuencia 3,2 GHz con tiempos 16-16-16-28CR1 a un voltaje de 1,35 V.

Las pruebas comenzaron el 20 de octubre de 2016 y se realizaron con el sistema operativo Microsoft Windows 10 Professional con todas las actualizaciones a esa fecha y con los siguientes controladores instalados:

Conjunto de chips de la placa base Controladores del conjunto de chips Intel - 10.1.1.38 WHQL del 12/10/2016;

Interfaz del motor de gestión de Intel (MEI) - 11.6.0.1025 WHQL de fecha 14/10/2016;

controladores de tarjeta grafica nvidia - GeForce 375.57 WHQL del 20/10/2016.

Dado que las tarjetas de video en las pruebas de hoy son muy productivas, se decidió rechazar las pruebas con una resolución de 1920 x 1080 píxeles y solo se utilizó una resolución de 2560 x 1440 píxeles. Las resoluciones son aún más altas, lamentablemente, el monitor existente no es compatible. Sin embargo, dados los resultados de las últimas actualizaciones, no hay necesidad de lamentar la falta de disponibilidad de resoluciones más altas. Para las pruebas, se utilizaron dos modos de calidad de gráficos: Calidad + AF16x: calidad de textura en los controladores de forma predeterminada con filtrado anisotrópico 16x habilitado y Calidad + AF16x + MSAA 4x (8x) con filtrado anisotrópico 16x habilitado y suavizado de pantalla completa 4x u 8x , en los casos , cuando el promedio de fotogramas por segundo se mantuvo lo suficientemente alto para un juego cómodo. En algunos juegos, debido a las especificidades de sus motores de juego, se utilizaron otros algoritmos de suavizado, que se indicarán más adelante en la metodología y en los diagramas. El filtrado anisotrópico y el suavizado de pantalla completa se habilitaron directamente en la configuración del juego. Si esta configuración no estaba disponible en los juegos, los parámetros se cambiaron en el panel de control del controlador GeForce. La sincronización vertical (V-Sync) también se deshabilitó a la fuerza allí. Además de lo anterior, no se realizaron cambios adicionales en la configuración del controlador.

Las tarjetas gráficas se probaron en una prueba de gráficos, una prueba de realidad virtual y quince juegos actualizados a las últimas versiones a la fecha de inicio del material. En comparación con nuestro anterior prueba de tarjeta de video los viejos y intensivos en recursos Thief y Sniper Elite III se excluyeron del conjunto de prueba, pero se incluyeron los nuevos Total War: WARHAMMER y Gears of War 4 con soporte para DirectX 12 API (ahora hay cinco juegos de este tipo en el conjunto) . Además, en los siguientes artículos sobre tarjetas de video, aparecerá en la lista otro juego nuevo con soporte para la API de DirectX 12. Así que ahora la lista de aplicaciones de prueba se ve así (los juegos y los resultados de otras pruebas están ordenados en el orden de su lanzamiento oficial):

3DMarca(DirectX 9/11) - versión 2.1.2973, probada en escenas Fire Strike, Fire Strike Extreme, Fire Strike Ultra y Time Spy (la puntuación gráfica se muestra en el diagrama);

SteamVR– prueba para el soporte de "realidad virtual", el resultado fue el número de tramas probadas durante la prueba;

Crisis 3(DirectX 11) - versión 1.3.0.0, todas las configuraciones de calidad gráfica al máximo, nivel de desenfoque medio, deslumbramiento habilitado, modos con FXAA y con MSAA 4x, doble pase secuencial de la escena con guión desde el comienzo de la misión Swamp con una duración de 105 segundos;

Última luz del metro(DirectX 11) – versión 1.0.0.15, se utilizó la prueba incorporada, configuración de calidad de gráficos y teselado en el nivel Muy alto, tecnología PhysX avanzada en dos modos de prueba, pruebas con SSAA y sin suavizado, ejecución secuencial doble del escena D6;

Battlefield 4(DirectX 11) - versión 1.2.0.1, todas las configuraciones de calidad de gráficos en Ultra, ejecución secuencial doble de la escena con guión desde el comienzo de la misión TASHGAR que dura 110 segundos;

Grand Theft Auto V(DirectX 11): compilación 877, configuración de muy alta calidad, ignorar límites sugeridos habilitado, V-Sync deshabilitado, FXAA habilitado, NVIDIA TXAA deshabilitado, reflejos de MSAA deshabilitados, sombras suaves de NVIDIA;

Rally de tierra(DirectX 11) - versión 1.22, se utilizó la prueba integrada en el juego en la pista de Okutama, la configuración de calidad de gráficos se estableció en el nivel máximo para todos los elementos, Mezcla avanzada - Activada; pruebas con MSAA 8x y sin suavizado;

batman: caballero de arkham(DirectX 11) - versión 1.6.2.0, configuración de calidad en Alta, Resolución de textura normal, Anti-Aliasing activado, V-Sync desactivado, pruebas en dos modos - con y sin activación de las dos últimas opciones de NVIDIA GameWorks, doble ejecución secuencial de el integrado en el juego de prueba;

(DirectX 11) - versión 4.3, configuración de calidad de textura en Muy Alta, Filtrado de Textura - Anisotrópico 16X y otras configuraciones de máxima calidad, pruebas con MSAA 4x y sin anti-aliasing, ejecución secuencial doble de la prueba integrada en el juego.

El ascenso del Tomb Raider(DirectX 12): versión 1.0 compilación 753.2_64, todos los parámetros configurados en Muy alto, Follaje dinámico - Alto, Oclusión ambiental - HBAO+, teselación y otras técnicas de mejora de la calidad activadas, dos ciclos de la prueba de referencia integrada (escena del valle geotérmico) sin anti-aliasing y con activación SSAA 4.0;

Far Cry Primal(DirectX 11) - versión 1.3.3, nivel de calidad máximo, texturas de alta resolución, niebla volumétrica y sombras al máximo, prueba de rendimiento incorporada sin anti-aliasing y con SMAA activado;

la división de Tom Clancy(DirectX 11) - versión 1.4, nivel de calidad máximo, todos los parámetros de mejora de imagen están activados, Temporal AA - Supersampling, modos de prueba sin suavizado y con activación SMAA 1X Ultra, prueba de rendimiento incorporada, pero corrigiendo los resultados de FRAPS;

Sicario(DirectX 12): versión 1.5.3, prueba integrada con configuración de calidad de gráficos establecida en "Ultra", SSAO habilitado, calidad de sombra "Ultra", protección de memoria deshabilitada;

Deus Ex: La humanidad dividida(DirectX 12): versión 1.10 compilación 592.1, todas las configuraciones de calidad configuradas manualmente al nivel máximo, teselación y profundidad de campo activadas, al menos dos ejecuciones consecutivas del punto de referencia integrado en el juego;

guerra total: martillo de guerra(DirectX 12) - versión 1.4.0 compilación 11973.949822, todas las configuraciones de calidad de gráficos al máximo nivel, reflejos habilitados, memoria de video ilimitada y SSAO activado, ejecución secuencial doble del punto de referencia integrado en el juego;

engranajes de guerra 4(DirectX 12): versión 9.3.2.2, configuración de calidad en Ultra, V-Sync deshabilitado, todos los efectos habilitados, escalado de resolución del 150 % (hasta 3840 x 2160) en lugar de suavizado no compatible con el juego, ejecución secuencial doble de el punto de referencia integrado en el juego.

Si los juegos implementaron la capacidad de fijar la cantidad mínima de cuadros por segundo, también se reflejó en los diagramas. Cada prueba se realizó dos veces, se tomó como resultado final el mejor de los dos valores obtenidos, pero solo si la diferencia entre ellos no superaba el 1%. Si las desviaciones de las pruebas superaban el 1 %, la prueba se repetía al menos una vez más para obtener un resultado fiable.

3. Resultados de la prueba de rendimiento

En los diagramas, los resultados de las pruebas de tarjetas de video sin overclocking se resaltan en verde y con overclocking, en turquesa oscuro. Dado que todos los resultados de los diagramas tienen un patrón común, no comentaremos cada uno de ellos por separado, sino que analizaremos los diagramas de resumen en la siguiente sección del artículo.3DMarca

SteamVR

Crisis 3

Última luz del metro

Battlefield 4

Grand Theft Auto V

Rally de tierra

batman: caballero de arkham

Tom Clancy's Rainbow Six: Siege

El ascenso del Tomb Raider

Far Cry Primal

la división de Tom Clancy

Sicario

Deus Ex: La humanidad dividida

guerra total: martillo de guerra

Dado que estamos probando Total War: WARHAMMER por primera vez, daremos la configuración en la que se probará este juego hoy y en nuestros artículos posteriores sobre tarjetas de video.

Y luego los resultados.

engranajes de guerra 4

También daremos la configuración del nuevo juego Gears of War 4, incluido en el set de prueba por primera vez.

Los resultados son los siguientes.

Complementemos los diagramas construidos con una tabla final con resultados de prueba con los valores promedio y mínimo derivados de la cantidad de cuadros por segundo para cada tarjeta de video.

Lo siguiente en la línea son los gráficos de resumen y el análisis de los resultados.

4. Cuadros resumen y análisis de resultados

En el primer par de diagramas resumen, proponemos comparar el rendimiento de la nueva NVIDIA TITAN X 12 GB en frecuencias nominales y la referencia NVIDIA GeForce GTX 980 Ti 6 GB también en frecuencias nominales. Los resultados de la última tarjeta de video se toman como punto de partida, y el FPS promedio de la tarjeta de video NVIDIA TITAN X se reserva como un porcentaje de la misma. La ventaja de la nueva tarjeta gráfica es, sin duda, impresionante.

En nuestras condiciones y configuraciones de prueba, la NVIDIA TITAN X es al menos un 48 % más rápida que la NVIDIA GeForce GTX 980 Ti, ¡y alcanza un asombroso 85 %! Teniendo en cuenta que la GeForce GTX 980 Ti en los juegos era en realidad igual a la GeForce TITAN X anterior, podemos decir que NVIDIA TITAN X es mucho más rápida que su predecesora. El progreso de una GPU Pascal en toda regla es increíble, es una pena que hasta ahora todo esto sea muy caro, pero la GeForce GTX 1080 Ti que ya parpadea en el horizonte será notablemente más asequible (la única pregunta es qué exactamente recortarán ?). Entonces, en promedio para todos los juegos con una resolución de 2560 x 1440 píxeles, NVIDIA TITAN X es más rápida que NVIDIA GeForce GTX 980 Ti en un 64,7 % en modos sin suavizado y en un 70,4 % cuando se activan varios algoritmos de suavizado.

Ahora vamos a evaluar cuánto le lleva NVIDIA TITAN X a la Gigabyte GeForce GTX 1080 G1 Gaming en frecuencias nominales con una fórmula de frecuencia llevada al nivel de las versiones de referencia de la GeForce GTX 1080.

Una vez más, ¡un aumento de rendimiento muy decente! Como mínimo, el nuevo producto es más rápido que la GeForce GTX 1080 en un 19 %, y en Rise of Tomb Raider su ventaja alcanza un impresionante 45,5 %. De media en todos los juegos, NVIDIA TITAN X es un 27,0 % más rápida en los modos sin suavizado y un 32,7 % más rápida con el suavizado habilitado.

Ahora soñemos que NVIDIA, al lanzar la GeForce GTX 1080 Ti, no reducirá el Pascal superior en términos de cantidad de bloques y la cantidad de procesadores shader, y al mismo tiempo sus socios lanzarán versiones originales con frecuencias aumentadas. ¿Cuánto más aumentará el rendimiento del buque insignia en este caso? La respuesta está en el siguiente cuadro resumen.

El overclocking de NVIDIA TITAN X en un 15,9 % en el núcleo y en un 12,4 % en la memoria de video acelera la tarjeta de video, que ya es asombrosamente rápida, en un 12,9 % en modos sin suavizado y en un 13,4 % con AA habilitado. Si volvemos al primer diagrama resumen, es fácil suponer que la GeForce GTX 1080 Ti original puede ser el doble de rápido referencia GeForce GTX 980 Ti o GeForce GTX TITAN X. Por supuesto, tal comparación no es objetiva, porque todos saben que la GeForce GTX 980 Ti original a menudo es capaz de hacer overclocking hasta 1.45-1.50 GHz en el núcleo, lo que significa la ventaja de potencial GeForce GTX 1080 Ti no será tan alto. Sin embargo, incluso un aumento del 60-70% en el rendimiento con respecto al buque insignia de la generación anterior no puede dejar de impresionar. ¿Dónde tenemos tú y yo un aumento similar en procesadores centrales o RAM? No hay nada igual, incluso en el segmento superior. ¡Y NVIDIA ya tiene tales capacidades!

5. Computación GPU

Primero, probaremos el rendimiento de la nueva tarjeta de video NVIDIA TITAN X en CompuBench CL versión 1.5.8. Las dos primeras pruebas son de reconocimiento facial basadas en el algoritmo Viola-Jones y en el cálculo del vector de movimiento de flujo óptico TV-L1.

Una vez más, el rendimiento de NVIDIA TITAN X es impresionante. En el modo de funcionamiento nominal, la novedad supera a la GeForce GTX 980 Ti de referencia en un 66,6 % en el test de detección de rostros y en un 90,4 % en el benchmark de flujo óptico TV-L1. La ventaja sobre la GeForce GTX 1080 también es bastante notable, y el overclocking de la nueva Titan acelera esta tarjeta de video en otro 8.1-12.1%. Sin embargo, se observó aproximadamente el mismo aumento de rendimiento en las otras dos tarjetas de video probadas con frecuencias crecientes.

El siguiente en la línea es la prueba de simulación de la superficie del océano para representar el movimiento de las olas de la superficie del agua utilizando la transformada discreta rápida de Fourier, así como la prueba de simulación de partículas para la simulación física de partículas.

Una característica distintiva de este par de pruebas fue la relativa cercanía de los resultados de la GeForce GTX 980 Ti y la GeForce GTX 1080, parece que el núcleo de Maxwell no se va a rendir fácilmente. Pero antes de la nueva TITAN X, ambas tarjetas de video ceden, perdiendo del 42,6 al 54,4 %.

Resultados mucho más densos en la prueba de composición de video.

La Gigabyte GeForce GTX 1080 G1 Gaming overclockeada incluso se las arregla para alcanzar a la NVIDIA TITAN X nominal, aunque esta última demuestra una ventaja del veinte por ciento sobre la GeForce GTX 980 Ti.

Pero en la simulación de minería de Bitcoin, nuevamente vemos la tremenda ventaja de NVIDIA TITAN X.

El nuevo producto es casi el doble de rápido que la GeForce GTX 980 Ti y un 30,4 % más rápido que la Gigabyte GeForce GTX 1080 G1 Gaming en las frecuencias de la referencia NVIDIA GeForce GTX 1080. A tal ritmo de crecimiento del rendimiento, NVIDIA y las tarjetas de video en A las GPU AMD les quedará muy poco.

El siguiente en la línea es la prueba GPGPU de la versión 5.75.3981 Beta de la utilidad AIDA64 Extreme. A partir de los resultados obtenidos, construimos gráficos para operaciones de punto flotante de precisión simple y doble.

Si la NVIDIA GeForce GTX TITAN X anterior estaba un 62 % por delante de la primera versión de GeForce GTX TITAN en estas pruebas, ¡entonces la nueva TITAN X en el núcleo Pascal supera a su predecesora en un 97,5 % a la vez! Para cualquier otro resultado de la prueba AIDA64 GPGPU, puede consultar el hilo de discusión del artículo en nuestro foro.

En conclusión, probemos la escena más compleja del último LuxMark 3.1: el vestíbulo del hotel.

Tenga en cuenta que la antigua GeForce GTX 980 Ti "no se rinde" Gigabyte GeForce GTX 1080 G1 Gaming en esta prueba, pero TITAN X la supera inmediatamente en un 58,5%. Rendimiento fenomenal! Aún así, es una lástima que NVIDIA siga retrasando el lanzamiento de la GeForce GTX 1080 Ti, y es especialmente una lástima que nadie lo esté presionando todavía.

6. Consumo de energía

El nivel de consumo de energía se midió utilizando la fuente de alimentación Corsair AX1500i a través de la interfaz Corsair Link y el programa del mismo nombre versión 4.3.0.154. Se midió el consumo de energía de todo el sistema en su conjunto, excluyendo el monitor. La medición se realizó en modo 2D durante el trabajo normal en Microsoft Word o navegando por Internet, así como en modo 3D. En el último caso, la carga se creó utilizando cuatro ciclos consecutivos de la escena de introducción del nivel Swamp del juego Crysis 3 a 2560 x 1440 píxeles con la configuración de calidad de gráficos máxima utilizando MSAA 4X. Las tecnologías de ahorro de energía de la CPU están deshabilitadas.Comparemos el consumo de energía de los sistemas con las tarjetas de video probadas hoy en el diagrama.

A pesar del enorme aumento en el rendimiento en todas partes y en todas partes, NVIDIA logró mantener el paquete térmico de la nueva TITAN X con un núcleo Pascal dentro de los mismos límites que la versión anterior de TITAN X: 250 vatios, por lo que el consumo de energía de los sistemas con estos video las tarjetas no difieren significativamente. Entonces, en el modo nominal, la configuración con NVIDIA TITAN X consume 41 watts más que con la tarjeta de video NVIDIA GeForce GTX 980 Ti, y cuando ambas tarjetas de video están overclockeadas, esta diferencia se reduce a 23 watts. Al mismo tiempo, notamos que un sistema con una Gigabyte GeForce GTX 1080 G1 Gaming es más económico que ambas versiones de TITAN X, y en frecuencias de la GeForce GTX 1080 de referencia casi cae dentro del límite de 400 vatios, y esto es teniendo en cuenta el hecho de que la configuración contiene un procesador de ocho núcleos decentemente overclockeado. Novedad más económica en modo 2D.

Conclusión

Dado que hoy en día las tarjetas de video NVIDIA representadas por GeForce GTX 1080 y GTX 1070 ocupan el liderazgo exclusivo en rendimiento en el segmento de precio superior, podemos considerar el lanzamiento de una TITAN X aún más productiva como la más demostrativa de su superioridad tecnológica sobre la única competidor. Además, esta demostración fue completamente exitosa porque, al estar en el mismo paquete térmico, la ventaja de la novedad sobre la tarjeta de video insignia de NVIDIA de la generación anterior en las pruebas de juegos a veces alcanza el 85%, ¡y en promedio es alrededor del 70%! No menos impresionante es el aumento del rendimiento en computación que, como sabemos, es primordial para las tarjetas de video de la serie NVIDIA TITAN.La diferencia de rendimiento con la GeForce GTX 1080 es un poco más modesta y asciende al 27-33 %, pero la ganancia de rendimiento del overclocking es mayor para la TITAN X (alrededor del 13 % frente al 10 % de la GeForce GTX 1080), lo que significa que cuando aparece la GeForce GTX 1080 Ti basada en la misma GP102 tenemos derecho a contar con frecuencias aún más altas y, en consecuencia, un aumento en el rendimiento. El punto negativo del anuncio de TITAN X es un aumento de doscientos dólares en el costo recomendado, sin embargo, en nuestra opinión, un aumento del costo del 20% no causará problemas serios para los consumidores potenciales de tales tarjetas de video. Bueno, los jugadores más modestos esperan con ansias la aparición de la GeForce GTX 1080 Ti, así como su competidor "rojo".

Además, destacamos que, a pesar del impresionante rendimiento en los juegos, la propia NVIDIA posiciona a TITAN X, en primer lugar, como una herramienta eficaz para entrenar redes neuronales y resolver problemas relacionados con los algoritmos de Deep Learning (aprendizaje profundo). Estos algoritmos ahora se utilizan activamente en varios campos: voz, imagen, reconocimiento de video, pronóstico hidrometeorológico, diagnósticos médicos más precisos, mapeo de alta precisión, robótica, autos sin conductor, etc. Por tanto, podemos decir que las posibilidades de la nueva tarjeta de vídeo NVIDIA TITAN X son ilimitadas y satisfarán a cualquier usuario.

Agradecemos a NVIDIA y personalmente a Irina Shekhovtsova

para la tarjeta de video proporcionada para la prueba.

La primera arquitectura Pascal de NVIDIA que salió al mercado fue la GeForce GTX 1080 basada en el procesador GP104. Gracias a la nueva tecnología de proceso FinFET de 16 nm, así como a las optimizaciones en la arquitectura y los circuitos del chip, la GTX 1080 logra un nivel de rendimiento de juego que es aproximadamente un 30 % superior al de la tarjeta gráfica insignia de la generación anterior de NVIDIA, la GeForce GTX. TITAN X. Al mismo tiempo, los desarrolladores de la GTX 1080 lograron reducir el presupuesto de energía del acelerador en 70 W en relación con el TDP de su predecesor, de 250 a 180 W. Mientras tanto, un paquete térmico de 250 W es un objetivo estándar para las mejores tarjetas de video para juegos de NVIDIA de las últimas generaciones, por lo que la aparición después de la GTX 1080 de un producto aún más productivo que ocupará este nicho en la línea Pascal era solo una cuestión. de tiempo.

A partir de la arquitectura Kepler, NVIDIA adoptó la siguiente estrategia para lanzar GPU en varias categorías de rendimiento. Primero, debuta el chip de segundo nivel: GK104 en la familia Kepler, GM204 en Maxwell versión 2 y ahora GP104 en Pascal. Posteriormente, NVIDIA llena uno o dos niveles por debajo, y después de una brecha significativa, aparece una GPU de primer nivel, que forma la base del acelerador más poderoso que NVIDIA puede producir, mientras mantiene el consumo de energía dentro de los 250 W con el flujo de trabajo actual.

El pico actual del desarrollo de la arquitectura Pascal es el procesador GP100, que presenta una cantidad sin precedentes de shader ALU (3840 núcleos CUDA) y 16 GB de memoria HBM2 combinados con una GPU en un sustrato de silicio. El GP100 se utiliza como parte del acelerador Tesla P100, cuyo uso está limitado al campo de las supercomputadoras debido a un factor de forma especial con un bus NVLINK y un TDP de 300 W. También se espera que Tesla P100 se lance en el formato de tarjeta de expansión PCI Express estándar a finales de año.

Era el chip GP100, en los sueños de los entusiastas de la industria, el que se suponía que coronaría la línea de adaptadores de juegos GeForce 10 en el futuro, y anteriormente NVIDIA podía lanzar un nuevo TITAN, solo con una parada intermedia en esta posición, el grande anterior Las GPU llegaron a las PC para juegos (GK110 como parte de TITAN y GM200, en TITAN X).

Sin embargo, esta vez, aparentemente, los expertos resultaron estar en lo correcto, prediciendo la división final de la línea de GPU NVIDIA en dos grupos que no se superponen: chips para juegos y direcciones de prosumidor (de las palabras productor y consumidor), por un lado. y chips para computación, por el otro. El factor diferenciador en este caso es la velocidad de la GPU en operaciones sobre números de punto flotante de doble precisión (FP64). En la línea Kepler, los desarrolladores ya sacrificaron esta característica para todos los chips (1/24 de FP32), además del anterior: GK110 / GK210 (1/3 de FP32), para reducir el consumo de energía de la GPU. En la siguiente generación, esta tendencia empeoró: todos los procesadores Maxwell ejecutan FP64 a una velocidad de 1/32 desde FP32.

La situación con Pascal mostró que los ahorros en el rendimiento del FP64 no se quedaron en una medida temporal debido a un retraso en la tecnología de proceso de 28 nm. NVIDIA aún necesita una GPU para servidores, supercomputadoras y estaciones de trabajo que puedan manejar FP64 a un alto nivel de rendimiento. Sin embargo, para los adaptadores de video para juegos, esta funcionalidad, que infla el presupuesto del transistor y el consumo de energía de la GPU, es solo una carga.

Por lo tanto, en lugar de portar el GP100 (un chip obviamente costoso de fabricar tanto por el área como por la memoria HBM2 integrada) a tarjetas de video para juegos, NVIDIA lanzó un producto adicional: GP102, enfocado en operaciones con FP32, el principal formato de número utilizado en Representación de gráficos 3D y en una serie de tareas computacionales. La única característica funcional del GP102 es el soporte para operaciones con enteros del formato int8. Este es un punto importante para NVIDIA, ya que int8 es ampliamente utilizado en tareas de aprendizaje automático, que la empresa ha convertido en una de las áreas prioritarias (más específicamente, una de las clases de tales tareas es el aprendizaje profundo). En un futuro próximo, planeamos publicar un artículo separado dedicado a este tema.

El nuevo TITAN X, que es el primer dispositivo basado en el procesador GP102, se posiciona principalmente como un acelerador de nivel profesional diseñado para aplicaciones comerciales y de investigación relacionadas con el aprendizaje profundo. Esto se confirma por la ausencia de la marca GeForce en el nombre de la tarjeta. Sin embargo, las amplias capacidades de juego de la novedad también están fuera de toda duda. Todos los Titans lanzados anteriormente, además de sus funciones informáticas, fueron considerados como tarjetas gráficas premium para juegos, capaces de proporcionar una calidad gráfica y un rendimiento que no estaban disponibles en sus modelos actuales en la línea principal de GeForce.

⇡ NVIDIA GP102

Esta GPU está concebida como una alternativa a la supercomputadora GP100, que no es inferior a esta última en las funciones de renderizado de gráficos 3D y cálculos FP32. Al mismo tiempo, los creadores del GP102 han reducido todos los componentes que no corresponden al propósito del producto.

Por ejemplo, un solo SM (multiprocesador de transmisión, un bloque que combina núcleos CUDA junto con unidades de mapeo de texturas, programadores, despachadores y segmentos de memoria local) en GP100 contiene 64 núcleos CUDA para operaciones FP32, mientras que SM en GP102 tiene a este respecto una configuración heredada. de Maxwell: 128 núcleos CUDA. La distribución más fina de los núcleos CUDA en el GP100 permite que el procesador ejecute simultáneamente más flujos de instrucciones (y también grupos de subprocesos, deformaciones y bloques de deformación), y la cantidad total de tipos de almacenamiento dentro del SM, como memoria compartida (memoria compartida) y el archivo de registro, en términos de toda la GPU ha aumentado en comparación con la arquitectura Maxwell.

Diagrama de bloques de NVIDIA GP102

Además, en GP100, por cada 64 núcleos CUDA para operaciones de FP32, hay 32 núcleos para FP64, mientras que el SM en GP102 tiene una configuración heredada de Maxwell en este sentido: 128 núcleos CUDA para FP32 y 4 para FP64. De ahí el rendimiento truncado de doble precisión del GP102.

Finalmente, la GP100 tiene una caché L2 más grande: 4096 KB frente a los 3072 KB de la GP102. Y, por supuesto, el GP102 carece de un controlador de bus NVLINK, y los controladores de memoria HBM2 (con un ancho de bus total de 4096 bits) se reemplazan por controladores GDDR5X SDRAM. 12 de estos controladores de 32 bits proporcionan un bus de acceso a la memoria común de 384 bits.

En otros aspectos que nos interesan, los chips GP100 y GP102 son idénticos. Ambos troqueles contienen 3840 núcleos CUDA compatibles con FP32 y 240 mapeadores de textura, así como 96 ROP. Así, desde un punto de vista general, la estructura de las unidades de cómputo GP102 repite la del chip GP104, ajustada por cambios cuantitativos. Aunque todavía no conocemos algunos parámetros (caché L1, memoria compartida y tamaños de archivos de registro), probablemente sean los mismos en estas dos GPU.

El chip GP102, fabricado con tecnología de proceso FinFET de 16 nm en TSMC, contiene 12 mil millones de transistores en un área de 471 mm 2 . A modo de comparación: las características del GP100 son 15,3 mil millones de transistores y 610 mm 2. Esta es una diferencia muy significativa. Además, si TSMC no ha aumentado el tamaño de la fotomáscara para el proceso de 16 nm en comparación con 28 nm, entonces la GP100 está casi agotada, mientras que la arquitectura liviana de la GP102 permitirá a NVIDIA crear un núcleo más grande para el amplio mercado de consumo en el futuro, utilizando la misma línea de producción (lo que, sin embargo, es poco probable que suceda a menos que los desarrolladores reconsideren sus estándares TDP para los mejores modelos).

Con respecto a las diferencias entre la arquitectura Pascal y Maxwell, le recomendamos que consulte nuestra revisión de GeForce GTX 1080. En esta iteración, los desarrolladores han desarrollado las ventajas de la generación anterior y han compensado sus deficiencias inherentes.

Señalamos brevemente los siguientes puntos:

- compresión de color mejorada con proporciones de hasta 8:1;

- la función de proyección múltiple simultánea de PolyMorph Engine, que le permite crear hasta 16 proyecciones de la geometría de la escena en una sola pasada (para VR y sistemas con múltiples pantallas en la configuración NVIDIA Surround);

- la capacidad de interrumpir (preemption) durante la ejecución de una llamada de sorteo (durante el renderizado) y un flujo de comandos (durante los cálculos), que, junto con la distribución dinámica de los recursos informáticos de la GPU, brinda soporte completo para la computación asíncrona (Async Compute) - una fuente adicional de rendimiento en juegos bajo DirectX 12 API y latencia reducida en VR;

- controlador de pantalla compatible con las interfaces DisplayPort 1.3/1.4 y HDMI 2.b. Soporte para alto rango dinámico (HDR);

- Bus SLI con mayor ancho de banda.

⇡ especificaciones, precio

TITAN X no utiliza una versión completamente funcional de la GPU GP102: de 30 SM, dos están deshabilitados aquí. Así, en cuanto a número de núcleos CUDA y unidades de textura, el Titan iguala al Tesla P100, donde el chip GP100 también está parcialmente “cortado” (3584 núcleos CUDA y 224 unidades de textura).

El procesador gráfico de la novedad opera a frecuencias más altas (1417/1531 MHz) que en el Tesla P100 (hasta 1328/1480 MHz en la versión de supercomputadora y hasta 1300 MHz en el factor de forma de la placa PCI-Express). Aún así, las frecuencias del "Titan" son bastante conservadoras en comparación con las características de la GeForce GTX 1080 (1607/1733 MHz). Como veremos en los experimentos de overclocking, el factor limitante fue el consumo de energía del dispositivo, que NVIDIA fijó en sus familiares 250W.

TITAN X está equipado con SDRAM GDDR5X de 12 GB con un ancho de banda de 10 Gbps por pin. El bus de 384 bits proporciona transferencia de datos a una velocidad de 480 GB / s: en este indicador, TITAN X es solo ligeramente inferior al poseedor del récord actual: Radeon R9 Fury X, así como a otros productos AMD basados en GPU Fiji (512 GB/s).

| Fabricante | NVIDIA | |||||

| Modelo | GeForce GTX TITAN | GeForce GTX TITAN Negro | GeForce GTX TITAN Z | GeForce GTX TITAN X | GeForce GTX 1080 | TITAN X |

| GPU | ||||||

| Nombre | GK110 | GK110 | 2 × GK110 | GM200 | GP104 | GP102 |

| microarquitectura | Kepler | Kepler | Kepler | Maxwell | Pascal | Pascal |

| Tecnología de proceso, nm | 28nm | 28nm | 28nm | 28nm | FinFET de 16 nm | FinFET de 16 nm |

| Número de transistores, millones | 7 080 | 7 080 | 2×7080 | 8 000 | 7 200 | 12 000 |

| Frecuencia de reloj, MHz: Reloj base / Reloj de impulso | 837/876 | 889/980 | 705/876 | 1 000 / 1 089 | 1 607 / 1 733 | 1 417 / 1531 |

| Número de ALU de shader | 2 688 | 2 880 | 2×2880 | 3 072 | 2 560 | 3 584 |

| Número de superposiciones de textura | 224 | 240 | 2×240 | 192 | 160 | 224 |

| Número de ROP | 48 | 48 | 2×48 | 96 | 64 | 96 |

| RAM | ||||||

| Ancho de bus, bit | 384 | 384 | 2×384 | 384 | 256 | 384 |

| Tipo de chip | SDRAM GDDR5 | SDRAM GDDR5 | SDRAM GDDR5 | SDRAM GDDR5 | SDRAM GDDR5X | SDRAM GDDR5X |

| Frecuencia de reloj, MHz (ancho de banda por contacto, Mbps) | 1 502 (6 008) | 1 750 (7 000) | 1 750 (7 000) | 1 753 (7 012) | 1 250 (10 000) | 1 250 (10 000) |

| Volumen, MB | 6 144 | 6 144 | 2×6144 | 12 288 | 8 192 | 12 288 |

| bus de E/S | PCI Express 3.0 x16 | PCI Express 3.0 x16 | PCI Express 3.0 x16 | PCI Express 3.0 x16 | PCI Express 3.0 x16 | PCI Express 3.0 x16 |

| Actuación | ||||||

| Máximo rendimiento FP32, GFLOPS (basado en la frecuencia máxima especificada) | 4 709 | 5 645 | 10 092 | 6 691 | 8 873 | 10 974 |

| Rendimiento FP32/FP64 | 1/3 | 1/3 | 1/3 | 1/32 | 1/32 | 1/32 |

| Ancho de banda RAM, GB/s | 288 | 336 | 2×336 | 336 | 320 | 480 |

| Salida de imagen | ||||||

| Interfaces de salida de imagen | DL DVI-I, DisplayPort 1.2, HDMI 1.4a | DL DVI-D, DL DVI-I, DisplayPort 1.2, HDMI 1.4a | DL DVI-I, DisplayPort 1.2, HDMI 1.4a | DL DVI-D, DisplayPort 1.3/1.4, HDMI 2.0b | ||

| TDP, W | 250 | 250 | 375 | 250 | 180 | 250 |

| Precio minorista sugerido en el momento del lanzamiento (EE. UU., sin impuestos), $ | 999 | 999 | 2 999 | 999 | 599/699 | 1 200 |

| Precio de venta recomendado en el momento del lanzamiento (Rusia), frotar. | 34 990 | 35 990 | 114 990 | 74 900 | — / 54 990 | — |

En términos de rendimiento teórico, TITAN X es la primera tarjeta gráfica de GPU única que supera los 10 TFLOPS en rendimiento FP32. De los productos anteriores de NVIDIA, solo TITAN Z, construido sobre un par de chips GK110, era capaz de hacer esto. Por otro lado, a diferencia de la Tesla P100 (y de forma similar a la GeForce GTX 1060/1070/1080), la TITAN X se caracteriza por un rendimiento muy modesto en doble (1/32 de FP32) y media precisión (1/64 de FP32) cálculos, pero es capaz de realizar operaciones con números int8 a una velocidad 4 veces más rápida que con FP32. Otras GPU de la familia Pascal: GP104 (GeForce GTX 1070/1080, Tesla P4) y GP106 (GTX 1060) y GP100 (Tesla P100) también admiten int8 con una relación de rendimiento de 4:1 en relación con FP32, sin embargo, actualmente no lo sabemos. si esta es una funcionalidad limitada en las tarjetas gráficas de juegos GeForce.

TITAN X es una compra muy, muy cara, que solo decidirán aquellos que realmente quieran tener una tarjeta de video tan perfecta. NVIDIA ha aumentado el precio en $ 200 de los modelos anteriores de un solo procesador bajo esta marca a $ 1200. Esta vez, el dispositivo no se distribuye a través de socios y se vende exclusivamente en el sitio web de NVIDIA en varios países seleccionados. Rusia aún no está entre ellos.

⇡ Diseño

La carcasa de la tarjeta de video está hecha con el mismo estilo que los productos de la marca Founders Edition de la línea GeForce 10. El sistema de enfriamiento con un ventilador radial (turbina) está cubierto con una carcasa de metal y la superficie posterior del circuito impreso El tablero está protegido por una placa gruesa. Parte de este último se puede quitar para proporcionar acceso de aire sin obstáculos al enfriador de una tarjeta de video adyacente en modo SLI. Es curioso que, aunque formalmente TITAN X ya no pertenece a la familia GeForce, es esta inscripción, iluminada por LED verdes, la que aún luce en el costado de la tarjeta de video.

El diseño del disipador es el mismo que el de la GTX 1070/1080: la GPU emite calor a un disipador con una cámara de evaporación, mientras que los chips de RAM y los transistores convertidores de voltaje están cubiertos con un marco de aluminio masivo que lleva un bloque separado. de pequeñas aletas.

Por cierto, como descubrió uno de los propietarios de TITAN X, NVIDIA permite a los usuarios cambiar el sistema de enfriamiento de la tarjeta de video a algo más eficiente (por ejemplo, LSS) sin perder la garantía.

⇡ Pagar

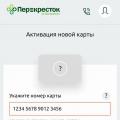

Al igual que las versiones de referencia de la GTX 1060/1070/1080, la placa TITAN X tiene tres conectores DisplayPort y uno de DVI y uno de HDMI.

El sistema de energía está construido de acuerdo con el esquema 6 + 1 (el número de fases para la GPU y los chips de memoria). Se utilizan dos conectores de alimentación adicionales: seis y ocho pines, que, junto con las líneas de alimentación en el conector PCI-Express, proporcionan a la tarjeta de video una reserva de energía de 300 vatios.

La memoria SDRAM GDDR5X, al igual que en la GeForce GTX 1080, está compuesta por microcircuitos Micron D9TXS con una frecuencia efectiva estándar de 10 GHz.

⇡ Banco de pruebas, metodología de prueba

| Configuración del banco de pruebas | |

|---|---|

| UPC | Intel Core i7-5960X a 4 GHz (100 × 40) |

| tarjeta madre | ASUS RAMPAGE V EXTREMO |

| RAM | Corsair Vengeance LPX, 2133 MHz, 4 × 4 GB |

| ROM | Intel SSD 520 240 GB + Crucial M550 512 GB |

| unidad de poder | Corsario AX1200i 1200W |

| Sistema de enfriamiento de la CPU | Arconte térmico derecho |

| Marco | Banco de pruebas CoolerMaster V1.0 |

| Monitor | NEC EA244UHD |

| Sistema operativo | Windows 10 Pro x64 |

| Software de GPU AMD | |

| Todo | Radeon Software Crimson Edition 16.8.2 No WHQL |

| Software de GPU NVIDIA | |

| Todo | Controlador GeForce Game Ready 372.54 WHQL |

La CPU funciona a una frecuencia constante. En la configuración del controlador NVIDIA, la CPU se selecciona como procesador para el cálculo de PhysX. En la configuración del controlador de AMD, la configuración de Tesselation se ha movido de AMD Optimized a Use application settings.

| Puntos de referencia: juegos | ||||

|---|---|---|---|---|

| Juego (en orden de fecha de lanzamiento) | API | Ajustes | Suavizado de pantalla completa | |

| 1920×1080 / 2560×1440 | 3840×2160 | |||

| Crysis 3 + FRAPS | DirectX 11 | máx. calidad. El comienzo de la misión Swamp. | MSAA 4x | Apagado |

| Campo de batalla 4 + FRAPS | máx. calidad. El comienzo de la misión Tashgar | MSAA 4x + FXAA Alto | ||

| Metro: Last Light Redux, punto de referencia incorporado | máx. calidad | SSAA 4x | ||

| GTA V, punto de referencia incorporado | máx. calidad | MSAA 4x + FXAA | ||

| Rally de tierra | máx. calidad | MSAA 4x | ||

| Rise of the Tomb Raider, punto de referencia incorporado | DirectX 12 | máx. calidad, VXAO apagado | SSAA 4x | |

| Tom Clancy's The Division, punto de referencia incorporado | DirectX 11 | máx. calidad, HFTS desactivado | SMAA 1x Ultra | |

| HITMAN, punto de referencia incorporado | DirectX 12 | máx. calidad | SSAA 4x | |

| Ashes of the Singularity, punto de referencia incorporado | DirectX 12 | máx. calidad | MSAA 4x + AA temporal 4x | |

| CONDENAR | vulcano | máx. calidad. fundición de la misión | TSSAA 8TX | |

| Total War: WARHAMMER, punto de referencia incorporado | DirectX 12 | máx. calidad | MSAA 4x | |

| Puntos de referencia: decodificación de video, computación | |

|---|---|

| Programa | Ajustes |

| Comprobador DXVA, punto de referencia de decodificación, H.264 | Archivos 1920 × 1080p (Perfil alto, L4.1), 3840 × 2160p (Perfil alto, L5.1). Decodificador de vídeo Microsoft H264 |

| Comprobador DXVA, punto de referencia de decodificación, H.265 | Archivos 1920 × 1080p (Perfil principal, L4.0), 3840 × 2160p (Perfil principal, L5.0). Decodificador de vídeo Microsoft H265 |

| LuxMark 3.1x64 | Escenario del vestíbulo del hotel (punto de referencia complejo) |

| Sony Vegas Pro 13 | Benchmark de Sony para Vegas Pro 11, 65 s de duración, renderizado en XDCAM EX, 1920 × 1080p 24 Hz |

| SiSoftware Sandra 2016 SP1, GPGPU Análisis científico | OpenCL, FP32/FP64 |

| CompuBench CL Desktop Edition X64, simulación de la superficie del océano | — |

| CompuBench CL Desktop Edition X64, simulación de partículas—64K | — |

⇡ Participantes de la prueba

Las siguientes tarjetas de video participaron en las pruebas de rendimiento:

- NVIDIA TITAN X (1417/10000 MHz, 12 GB);

⇡ Actuación: 3DMark

Las pruebas sintéticas muestran una ventaja promedio de TITAN X sobre GeForce GTX 1080 en un 25 %. En comparación con la generación anterior de la marca TITAN, así como con la Radeon R9 Fury X, el nuevo buque insignia ofrece un 61-63 % más de rendimiento y más del doble de rendimiento en comparación con la primera versión de TITAN basada en la arquitectura Kepler. La Radeon R9 295X2 ocupa una posición bastante alta en comparación con el acelerador NVIDIA: el nuevo producto es solo un 18% más rápido en 3DMark.

| 3DMark (puntuación gráfica) | |||||||

|---|---|---|---|---|---|---|---|

| Permiso | |||||||

| huelga de fuego | 1920×1080 | 26 341 | 10 449 | 17 074 | 21 648 | 23 962 | 16 279 |

| Golpe de fuego extremo | 2560×1440 | 13 025 | 4 766 | 7 945 | 10 207 | 10 527 | 7 745 |

| Golpe de fuego ultra | 3840×2160 | 6 488 | 2 299 | 4 011 | 4 994 | 5 399 | 3 942 |

| espía del tiempo | 2560×1440 | 8 295 | 2 614 | 4 935 | 6 955 | 7 186 | 5 084 |

| máx. | −60% | −35% | −16% | −9% | −38% | ||

| Promedio | −64% | −38% | −20% | −15% | −39% | ||

| mín. | −68% | −41% | −23% | −19% | −41% | ||

⇡ Rendimiento: juegos (1920×1080, 2560 × 1440)

En pruebas con una resolución relativamente baja para una GPU tan potente, la nueva TITAN X supera a la GeForce GTX 1080 en un 15-20 % (de 1080p a 1440p, respectivamente) en resultados promedio. El nuevo buque insignia parece aún más impresionante en comparación con los mejores aceleradores del período de 28 nm: es un 47-56 % más rápido que la GeForce GTX TITAN X basada en la GM200 y un 67-72 % por delante de la Radeon R9 Fury X.

Si tomamos el primer TITAN de la generación Kepler, entonces estamos hablando de un aumento de más del doble en el rendimiento.

| 1920×1080 | |||||||

|---|---|---|---|---|---|---|---|

| Suavizado de pantalla completa | NVIDIA TITAN X (1417/10000 MHz, 12 GB) | NVIDIA GeForce GTX TITAN (837/6008 MHz, 6 GB) | NVIDIA GeForce GTX TITAN X (1000/7012 MHz, 12 GB) | NVIDIA GeForce GTX 1080 (1607/10008 MHz, 8 GB) | AMD Radeon R9 295X2 (1018/5000 MHz, 8 GB) | AMD Radeon R9 furia X (1050/1000 MHz, 4 GB) | |

| Cenizas de la Singularidad | MSAA 4x | 47 | 20 | 31 | 42 | 34 | 26 |

| Battlefield 4 | MSAA 4x + FXAA Alto | 162 | 71 | 118 | 149 | 134 | 94 |

| Crisis 3 | MSAA 4x | 99 | 45 | 65 | 79 | 90 | 60 |

| Rally de tierra | MSAA 4x | 126 | 57 | 83 | 101 | 97 | 65 |

| CONDENAR | TSSAA 8TX | 200 | 69 | 151 | 185 | 122 | 156 |

| gta v | MSAA 4x + FXAA | 85 | 44 | 68 | 84 | 76 | 52 |

| SICARIO | SSAA 4x | 68 | 21 | 39 | 52 | 24 | 33 |

| Metro: Última luz Redux | SSAA 4x | 124 | 47 | 73 | 92 | 94 | 70 |

| El ascenso del Tomb Raider | SSAA 4x | 70 | 28 | 47 | 62 | 55 | 41 |

| la división de Tom Clancy | SMAA 1x Ultra | 87 | 35 | 59 | 80 | 57 | 58 |

| guerra total: martillo de guerra | MSAA 4x | 76 | 38 | 56 | 73 | 37 | 49 |

| máx. | −48% | −20% | −0% | −9% | −22% | ||

| Promedio | −58% | −32% | −13% | −29% | −40% | ||

| mín. | −69% | −43% | −26% | −65% | −51% | ||

| 2560×1440 | |||||||

|---|---|---|---|---|---|---|---|

| Suavizado de pantalla completa | NVIDIA TITAN X (1417/10000 MHz, 12 GB) | NVIDIA GeForce GTX TITAN (837/6008 MHz, 6 GB) | NVIDIA GeForce GTX TITAN X (1000/7012 MHz, 12 GB) | NVIDIA GeForce GTX 1080 (1607/10008 MHz, 8 GB) | AMD Radeon R9 295X2 (1018/5000 MHz, 8 GB) | AMD Radeon R9 furia X (1050/1000 MHz, 4 GB) | |

| Cenizas de la Singularidad | MSAA 4x | 39 | 16 | 24 | 33 | 27 | 21 |

| Battlefield 4 | MSAA 4x + FXAA Alto | 109 | 47 | 75 | 98 | 95 | 65 |

| Crisis 3 | MSAA 4x | 63 | 27 | 40 | 53 | 59 | 39 |

| Rally de tierra | MSAA 4x | 93 | 40 | 60 | 74 | 71 | 48 |

| CONDENAR | TSSAA 8TX | 166 | 45 | 95 | 126 | 82 | 107 |

| gta v | SMAA | 67 | 31 | 48 | 63 | 61 | 39 |

| SICARIO | MSAA 4x + FXAA | 43 | 13 | 24 | 33 | 12 | 17 |

| Metro: Última luz Redux | SSAA 4x | 71 | 26 | 43 | 52 | 54 | 43 |

| El ascenso del Tomb Raider | No soportado | 44 | 16 | 28 | 38 | 23 | 27 |

| la división de Tom Clancy | SSAA 4x | 63 | 24 | 43 | 58 | 45 | 44 |

| guerra total: martillo de guerra | SMAA 1x Alto | 57 | 26 | 39 | 50 | 25 | 34 |

| máx. | −53% | −29% | −6% | −6% | −30% | ||

| Promedio | −61% | −36% | −16% | −33% | −42% | ||

| mín. | −73% | −44% | −27% | −72% | −60% | ||

Nota:

⇡ Rendimiento: juegos (3840 × 2160)

Al pasar de 1440p a 4K, la relación entre las tarjetas gráficas NVIDIA sigue siendo la misma. La TITAN X es un 20 % más rápida que la GeForce GTX 1080 y un 56 % más rápida que la TITAN X basada en Maxwell.

La Radeon R9 Fury X, que es típica de este modelo, hace frente de manera más efectiva a las pruebas en 4K, lo que finalmente redujo la ventaja del "Titán" al 56%.

| 3840×2160 | |||||||

|---|---|---|---|---|---|---|---|

| Suavizado de pantalla completa | NVIDIA TITAN X (1417/10000 MHz, 12 GB) | NVIDIA GeForce GTX TITAN (837/6008 MHz, 6 GB) | NVIDIA GeForce GTX TITAN X (1000/7012 MHz, 12 GB) | NVIDIA GeForce GTX 1080 (1607/10008 MHz, 8 GB) | AMD Radeon R9 295X2 (1018/5000 MHz, 8 GB) | AMD Radeon R9 furia X (1050/1000 MHz, 4 GB) | |

| Cenizas de la Singularidad | Apagado | 45 | 20 | 29 | 41 | 38 | 37 |

| Battlefield 4 | 84 | 35 | 57 | 74 | 72 | 52 | |

| Crisis 3 | 42 | 18 | 28 | 36 | 40 | 29 | |

| Rally de tierra | 65 | 26 | 41 | 50 | 48 | 33 | |

| CONDENAR | 92 | 24 | 51 | 68 | 45 | 57 | |

| gta v | 55 | 25 | 39 | 51 | 49 | 34 | |

| SICARIO | 67 | 21 | 38 | 53 | 24 | 33 | |

| Metro: Última luz Redux | 64 | 23 | 38 | 47 | 47 | 38 | |

| El ascenso del Tomb Raider | 50 | 19 | 33 | 44 | 37 | 31 | |

| la división de Tom Clancy | 38 | 15 | 25 | 33 | 26 | 28 | |

| guerra total: martillo de guerra | 43 | 20 | 30 | 38 | 20 | 32 | |

| máx. | −53% | −29% | −7% | −5% | −18% | ||

| Promedio | −61% | −36% | −16% | −29% | −36% | ||

| mín. | −74% | −45% | −27% | −64% | −51% | ||

Nota: Total War: WARHAMMER no es compatible con DirectX 12 para GeForce GTX TITAN.

⇡ Rendimiento: decodificación de video

La GP102 integra el mismo códec de hardware que las dos GPU junior de la familia Pascal, por lo que TITAN X demuestra la velocidad de decodificación de los estándares H.264 y HEVC a la par de la GeForce GTX 1080, ajustada para velocidades de reloj de GPU más bajas. El rendimiento de Pascal en esta tarea es insuperable, tanto en comparación con los códecs de NVIDIA en los chips Maxwell como con los de AMD Polaris.

Nota: dado que los decodificadores no suelen diferir dentro de la misma línea de GPU, los diagramas muestran un dispositivo de cada familia (o más si se infringe esta regla).

Nota. 2: GeForce GTXTITÁN X, al igual que otros dispositivos basados en la arquitectura de GPU Maxwell, con la excepción del GM204 (GeForce GTX 950/960), realiza una decodificación de hardware H.265 parcial respaldada por recursos de CPU.

⇡ Rendimiento: Informática

La relación entre las diferentes arquitecturas en las tareas de GPGPU depende de las características específicas de cada aplicación. La TITAN X proporciona ganancias de rendimiento predecibles sobre la GeForce GTX 1080 en su mayor parte, pero hay casos excepcionales en los que la tarea depende de la frecuencia de la GPU (como la prueba de física de partículas en CompuBench CL y el renderizado en Sony Vegas): aquí el La ventaja está del lado de la GTX 1080. Por el contrario, la nueva TITAN X se vengó en una situación en la que la GeForce GTX 1080 es inferior a la TITAN X basada en Maxwell y la Radeon R9 Fury X (trazado de rayos en LuxMark).

En la prueba de multiplicación de matrices y transformada rápida de Fourier de SiSoftware Sandra, la TITAN X sobresale en el modo FP32. En cuanto a FP64, simplemente debido a la fuerza bruta (una gran cantidad de núcleos CUDA y altas velocidades de reloj), el acelerador logró un rendimiento más alto que el TITAN original de la generación Kepler y Radeon R9 Fury X, tarjetas de video que tienen una relación más favorable. de rendimiento con FP32 y FP64. En última instancia, esto no descarta por completo a TITAN X como un acelerador de tareas de doble precisión. Sin embargo, la Radeon R9 295X2 es la más adecuada para este propósito. Las tarjetas de video AMD también ocupan posiciones sólidas en algunas otras pruebas: cálculo de la superficie del agua en CompuBench CL y Sony Vegas.

⇡ Velocidades de reloj, consumo de energía, temperatura, overclocking

Bajo carga de juego, la GPU TITAN X alcanza periódicamente las mismas altas velocidades de reloj que la GP104 en la GTX 1080 (1848 frente a 1860 MHz), pero la mayor parte del tiempo permanece en un rango significativamente más bajo (1557-1671 MHz). Al mismo tiempo, la tensión de alimentación máxima de la GPU es de 1,062 V (1,05 V en la GTX 1080).

El ventilador de CO gira a velocidades de hasta 2472 rpm. La tarjeta requiere una refrigeración más potente que la GTX 1080 y, dado que el diseño del sistema de refrigeración no ha cambiado, genera más ruido. Para compensar este factor, TITAN X ha establecido una temperatura de GPU objetivo 3 °C más alta.

Aunque la TITAN X basada en Pascal técnicamente tiene el mismo TDP que la TITAN X de la generación anterior, en la práctica, un sistema con una nueva tarjeta de video desarrolla significativamente más potencia (en 49 W). Sin embargo, el aumento de la carga en la CPU, que sirve a un procesador de gráficos más eficiente, puede desempeñar un papel aquí. En FurMark, en cambio, todos los aceleradores con un TDP de 250W (así como el Fury X de 275W) están al mismo nivel.

Para hacer overclocking en la Titan, aprovechamos la capacidad de stock para aumentar el límite de potencia de la tarjeta gráfica en un 20 %, hacer funcionar la turbina de CO a máxima velocidad (4837 rpm) y aumentar el voltaje máximo de la GPU a 1,093 V (el mismo valor que en la GTX 1080). Como resultado, pudimos aumentar la frecuencia de GPU base en 200 MHz a 1617 MHz y la frecuencia de memoria efectiva a 11100 MHz.

Esto por sí solo no es malo para un chip tan grande, pero el mayor límite de potencia no es menos importante. La GPU overclockeada admite frecuencias en el rango de 1974-1987 MHz, con un máximo de 2063 MHz, que es nada menos que un logro asombroso. A modo de comparación: la frecuencia máxima de la GPU en nuestra instancia GTX 1080 durante el overclocking fue de 2126 MHz.

Un sistema con una TITAN X overclockeada ofrece 46 W más de potencia que la tarjeta gráfica estándar. El ventilador que se puso en marcha a su velocidad máxima redujo la temperatura de la GPU entre 17 y 20 °C, lo que permite a los usuarios esperar un overclocking igualmente efectivo a RPM más bajas, proporcionando un nivel de ruido relativamente cómodo.

⇡ Rendimiento: overclocking

El overclocking de TITAN X permite un aumento muy significativo en el rendimiento: un 14 % en 3DMark y un 18-23 % en los puntos de referencia de juegos con resoluciones de 1080p y 1440p. En juegos a resolución 4K, la bonificación alcanza el 26%.

La diferencia entre una TITAN X overclockeada y una GeForce GTX 1080 funcionando a frecuencias de referencia alcanza valores impactantes del 36%, 47% y 50% en las tres resoluciones que utilizamos. Por supuesto, la GTX 1080 en sí misma también está sujeta a overclocking, pero como recordamos de nuestra revisión de la tarjeta de video de referencia, esto agrega solo 9, 13 y 12% a los resultados. Por lo tanto, si comparamos el buque insignia overclockeado de la línea GeForce 10 y el TITAN X overclockeado, la ventaja de este último será del 25, 30 y 34%.

Utilizando los datos de rendimiento de nuestro antiguo chip GeForce GTX TITAN X GM200 overclockeado, haremos cálculos similares para comparar dos generaciones de Titans. El TITAN X overclockeado en Pascal está por delante de su predecesor por 75, 93 y 97%. Cuando ambos aceleradores están overclockeados, la novedad mantiene una ventaja de 74 y 70% a resoluciones de 1440p y 2160p. Nosotros (como recordarán los lectores que criticaron esta decisión) nos negamos a probar en modo 1080p en la revisión de GeForce GTX TITAN X.

| 3DMark (puntuación gráfica) | ||||||

|---|---|---|---|---|---|---|

| Permiso | NVIDIA GeForce GTX 1080 (1607/10008 MHz, 8 GB) | NVIDIA TITAN X (1417/10000 MHz, 12 GB) | ||||

| huelga de fuego | 1920×1080 | 21 648 | 26 341 | 31 038 | ||

| Golpe de fuego extremo | 2560×1440 | 10 207 | 13 025 | 15 191 | ||

| Golpe de fuego ultra | 3840×2160 | 4 994 | 6 488 | 7 552 | ||

| espía del tiempo | 2560×1440 | 6 955 | 8 295 | 8 644 | ||

| máx. | +30% | +51% | ||||

| Promedio | +25% | +42% | ||||

| mín. | +19% | 101 | 126 | 126 | ||

| CONDENAR | TSSAA 8TX | 185 | 200 | 200 | ||

| gta v | MSAA 4x + FXAA | 84 | 85 | 96 | ||

| SICARIO | SSAA 4x | 52 | 68 | 77 | ||

| Metro: Última luz Redux | SSAA 4x | 92 | 124 | 140 | ||

| El ascenso del Tomb Raider | SSAA 4x | 62 | 70 | 94 | ||

| la división de Tom Clancy | SMAA 1x Ultra | 80 | 87 | 117 | ||

| guerra total: martillo de guerra | MSAA 4x | 73 | 76 | 88 | ||

| máx. | +35% | +57% | ||||

| Promedio | +16% | +36% | ||||

| mín. | +0% | +8% | ||||

| 2560×1440 | ||||

|---|---|---|---|---|

| Suavizado de pantalla completa | NVIDIA GeForce GTX 1080 (1607/10008 MHz, 8 GB) | NVIDIA TITAN X (1417/10000 MHz, 12 GB) | NVIDIA TITAN X (1617/11110 MHz, 12 GB) | |

| Cenizas de la Singularidad | MSAA 4x | 33 | 39 | 48 |

| Battlefield 4 | MSAA 4x + FXAA Alto | 98 | 109 | 146 |

| Crisis 3 | MSAA 4x | 53 | 63 | 81 |

| Rally de tierra | MSAA 4x | 74 | 93 | 93 |

| CONDENAR | TSSAA 8TX | 126 | 166 | 183 |

| gta v | SMAA | 63 | 67 | 86 |

| SICARIO | MSAA 4x + FXAA | 33 | 43 | 49 |

| Metro: Última luz Redux | SSAA 4x | 52 | 71 | 82 |

| El ascenso del Tomb Raider | No soportado | 38 | 44 | 59 |

| la división de Tom Clancy | SSAA 4x | 58 | 63 | 86 |

| guerra total: martillo de guerra | SMAA 1x Alto | 50 | 57 | 74 |

| máx. | +36% | +58% | ||

| Promedio | +20% | +47% | ||

| mín. | ||||

| CONDENAR | 68 | 92 | 104 | |

| gta v | 51 | 55 | 75 | |

| SICARIO | 53 | 67 | 77 | |

| Metro: Última luz Redux | 47 | 64 | 74 | |

| El ascenso del Tomb Raider | 44 | 50 | 69 | |

| la división de Tom Clancy | 33 | 38 | 52 | |

| guerra total: martillo de guerra | 38 | 43 | 58 | |

| máx. | +37% | +59% | ||

| Promedio | ||||

La aceleradora de video GeForce GTX Titan X es actualmente (abril de 2015) la más avanzada tecnológicamente del mundo. Tiene un rendimiento incomparable que no tiene paralelo en el mundo. La tarjeta gráfica Titan X está diseñada para jugadores profesionales y experimentados, así como para entusiastas de la PC. La placa se basa en la nueva arquitectura Maxwell de NVIDIA, que se caracteriza por duplicar el rendimiento en comparación con la generación anterior de GPU Kepler y una increíble eficiencia energética.

La tarjeta gráfica GeForce GTX Titan X está equipada con la GPU GM200, que incluye absolutamente todos los núcleos 3072 CUDA, que es el valor máximo para la línea GeForce GTX 900.

La innovadora GPU GM200 tiene una serie de impresionantes tecnologías de juego que son heredadas de generaciones anteriores de aceleradores y fueron desarrolladas por ingenieros de NVIDIA desde cero. Junto con tecnologías reconocidas para admitir pantallas 3D Vision 3D, sincronización adaptativa G-Sync y algoritmos anti-aliasing MSAA y TXAA, las tarjetas de video de la familia GeForce GTX 900 han introducido la tecnología Multi-Frame Anti-Aliasing (MFAA), que garantiza una aumento de rendimiento del 30%; método anti-aliasing usando DSR de ultra alta resolución; y Voxel Global Illumination (VXGI), que acelera los efectos de iluminación dinámicos para un juego inmersivo de calidad cinematográfica.

Este acelerador, al igual que otras tarjetas en la línea, recibió una tecnología actualizada de overclocking automático NVIDIA GPU Boost 2.0, que monitorea el funcionamiento de la tarjeta de video, administrando de manera aún más efectiva la temperatura de la GPU, el overclocking del procesador y el voltaje, lo que le permite maximizar el rendimiento de la GPU.

El producto incorpora la tecnología NVIDIA Adaptive Vertical Sync. Esta tecnología se habilita a velocidades de cuadro altas para eliminar el desgarro y se desactiva a velocidades de cuadro bajas para minimizar la vibración de cuadro.

El desarrollador garantiza el funcionamiento completo de la tarjeta de video con la nueva API Microsoft DirectX 12, que puede reducir significativamente la carga en la CPU y acelerar la representación de imágenes.

Con todo, el nuevo acelerador es la solución perfecta para juegos UHD 4K de ultra alta resolución con la configuración de la más alta calidad. También proporciona un rendimiento suficiente en la creciente popularidad de los sistemas de realidad virtual.

Ventajas

Máximo rendimiento La solución de máximo rendimiento para entusiastas le permite jugar todos los juegos de PC más recientes con una resolución de 4K y la más alta calidad de imagen. Tiene un margen significativo para futuros juegos. La capacidad de agrupación de soporte SLI le permite crear configuraciones de tarjeta doble, triple y cuádruple (cuando se utiliza una placa base compatible con SLI) para mejorar aún más el rendimiento de los juegos. Conexión de pantallas adicionales Utilice simultáneamente Dual-link DVI, HDMI y DisplayPort para configuraciones de varios monitores con hasta 4 pantallas. Buen overclocking Gracias a la tecnología madura de GPU de 28 nm y la alta eficiencia energética de la arquitectura Maxwell, la tarjeta gráfica GeForce GTX Titan X tiene excelentes capacidades de overclocking de GPU. Los overclockers profesionales pueden overclockear la GPU de este acelerador 2 veces. Buen rendimiento de video Decodificación totalmente acelerada de todos los principales formatos de video, tanto en discos DVD/Blu-ray como desde Internet, compatibilidad con función de imagen en imagen, compatibilidad con aceleración CUDA/OpenCL/DirectX para codificadores y editores de video, hardware HEVC decodificación Listo para estéreo 3D Vision La tarjeta tiene un rendimiento más que suficiente para ofrecer juegos estéreo completos cuando se usa el kit NVIDIA 3D Vision (requiere un monitor compatible). Compatibilidad con aceleración de PhysX El procesador de gráficos tiene suficiente potencia para calcular simultáneamente gráficos 3D y efectos especiales adicionales en juegos habilitados para PhysX. Bajo consumo de energía Gracias a la nueva arquitectura GPU, este acelerador de video tiene la más alta eficiencia energética. Como resultado, una fuente de alimentación más modesta (a partir de 600 W) es suficiente para su funcionamiento que para la solución superior de la generación anterior, la aceleradora GeForce GTX Titan Z. Preparada para la realidad virtual La tarjeta cuenta con la tecnología VR Direct, que es especialmente diseñado para trabajar con dispositivos de realidad virtual. El desarrollo implica el uso de varias tarjetas gráficas en una configuración SLI, incluye la tecnología Asynchronous Warp, que reduce los retrasos de la imagen y ajusta rápidamente la imagen según la rotación del cabezal, y Auto Stereo, que aumenta la compatibilidad de los juegos con dispositivos de realidad virtual. como el Oculus Rift.Defectos

Precio alto El costo de más de 1000 dólares estadounidenses y más limita significativamente el círculo de compradores. Altos requisitos del sistema Para aprovechar al máximo la tarjeta, es deseable una configuración de PC "costosa", que incluya una placa base moderna con soporte PCI Express 3.0, la CPU más potente, memoria DDR4 y un SSD PCI-e para ejecutar juegos.| conjunto de chips |

|---|

La tarjeta gráfica TITAN X está diseñada para los fanáticos de los juegos que más recursos demandan. Combina la última tecnología con el rendimiento extremo de la nueva arquitectura NVIDIA Maxwell™ para ofrecer la tarjeta gráfica más rápida y avanzada del planeta.

MAYOR RENDIMIENTO

TITAN X continúa el legado de la familia de tarjetas gráficas TITAN y ofrece la GPU para juegos de mayor rendimiento del mundo. Utiliza la poderosa arquitectura Maxwell para ofrecer la última tecnología con el doble de rendimiento y eficiencia energética que la tarjeta gráfica GTX TITAN original.

![]()

DISEÑO EXTRAORDINARIO

La TITAN X está diseñada y construida por expertos con componentes de alta calidad para ofrecer mejoras significativas en el rendimiento al mismo tiempo que mantiene un rendimiento acústico y térmico insuperable.

Esta GPU avanzada admite iluminación global hiperrealista en tiempo real con la tecnología NVIDIA VXGI, así como la tecnología NVIDIA G-SYNC™, que garantiza un juego fluido y sin interrupciones. Además, podrá disfrutar de la tecnología DSR, que ofrece una experiencia 4K incluso en pantallas de 1080p.

![]()

JUEGOS EXTREMOS

TITAN X es la única tarjeta gráfica de una sola GPU que puede reproducir fácilmente juegos 4K en configuraciones altas. Funciona sin problemas gracias a la aplicación GeForce® Experience™, que brinda acceso a los controladores más recientes y optimiza la configuración del juego con un solo clic. Incluso puede grabar sus mejores momentos de juego y compartirlos con sus amigos mediante la tecnología NVIDIA® ShadowPlay™.